kann also mit der

Formel

kann also mit der

Formel  berechnet werden, wobei b die Basis ist. Z.B. hat die

Binärzahl 101 den Wert

1*22+0*21+1*20=1*4+1*1=5.

berechnet werden, wobei b die Basis ist. Z.B. hat die

Binärzahl 101 den Wert

1*22+0*21+1*20=1*4+1*1=5.

Weiters ist Programmieren eine Fertigkeit, die man sich weniger durch Anhören von Vorlesungen und Lesen von Büchern erwirbt, sondern vor allem, indem man selbst programmiert. Allerdings können Bücher und Vorlesungen helfen, den Horizont zu erweitern, sodass man nicht immer auf den selben Trampelpfaden unterwegs ist.

Zu beachten ist allerdings auch, dass die Informatik nicht nur aus Programmieren besteht.

Es gibt verschiedene Forth-Systeme; für diese LVA verwenden wir Gforth (einige Gforth-spezifische Fähigkeiten werden verwendet). Gforth ist für Linux üblicherweise über die Linux-Distribution verfügbar, und für Windows hier als selbstinstallierendes Executable. Für MacOS X gibt es eine Erfolgsmeldung für das Gforth-Paket auf Homebrew. Fuer Android-Smartphones gibt es Gforth auf Google Play.

Fangen wir damit an, den Computer den Satz einmal schreiben zu lassen:

." I will not do anything bad ever again."Zu beachten ist dabei das Leerzeichen nach

." . Probieren Sie aus, was passiert, wenn

Sie es weglassen. Sie sehen: Computer, insbesondere

Programmiersprachen, sind pedantisch. Dabei

ist ." ein Befehl, oder, in Forth-Terminologie,

ein Wort, der die Eingabe bis zum

nächsten " ausgibt.

Sie können in Gforth mit der Pfeil-Hinauf-Taste die zuletzt eingegebene Zeile (bei wiederholter Anwendung die davor) wieder in die Kommandozeile holen und dann mit der Enter-Taste wieder ausführen, und auf diese Weise die Ausgabe mit wenig Aufwand wiederholen.

Aber auf die Dauer ist es praktischer, wenn wir dieser Aktion einen kurzen Namen geben:

: bart ." I will not do anything bad ever again." ;Jetzt können wir diese Aktion wie folgt ausführen:

bartMit

: bart haben wir die Definition des

Wortes bart angefangen. Danach kam das, was passieren

soll, wenn Sie das Wort ausführen. Die Definition wird

mit ; beendet.

Sie können bart jetzt beliebig oft ausführen:

bart bart bart bart bartDa haben wir auch schon den ersten Fehler: Jede Ausgabe schliesst unmittelbar an die vorige an, anstatt auf einer neuen Zeile zu beginnen. Korrigieren wir das, indem wir

bart anders

definieren:

: bart cr ." I will not do anything bad ever again." ;Das Wort

cr

(für Carriage

Return) bewirkt, dass die Ausgabe am Anfang der nächsten Zeile

fortgesetzt wird.

Jetzt können wir die Ausgabe leicht 20 mal machen lassen:

bart bart bart bart bart bart bart bart bart bart bart bart bart bart bart bart bart bart bart bartDas ist zwar schon eine schöne Ersparnis im Vergleich zur Originalaufgabe, aber noch immer recht repetetiv. Auch das können wir bald besser, aber davor müssen wir uns noch mit Daten befassen. Dann können wir irgendwann auch Programme schreiben, die nicht nur immer das gleiche machen, sondern auch Eingaben verarbeiten und auf sie reagieren.

Umgekehrt kann das selbe Datum auf verschiedene Arten interpretiert werden und hat dann verschiedene Bedeutungen. Zum Beispiel kann die Zahl 65 ein Preis sein, eine Gewichtsangabe, eine Entfernung, usw. Deswegen gibt man in solchen Fällen normalerweise auch die Einheit als Kontext mit an: z.B. EUR65, 65N, 65km.

Interessanterweise hat sich das Arbeiten mit Einheiten in der Programmierung nicht durchgesetzt, obwohl da auch schon einige kostspielige Fehler passiert sind. Jedenfalls werden Zahlen in praktisch allen Programmiersprachen ohne Dimension und ohne Einheit verwendet, und Ihre Bedeutung erhalten Sie durch die Verwendung im Programm.

Auf einer maschinennahen Ebene werden alle Daten irgendwie mit Bits dargestellt. Ein Bit kann zwei Werte annehmen; ein Beispiel wäre, das Geschlecht als Bit darzustellen, die beiden Werte sind dabei "weiblich" und "männlich". Wenn man ein Bit als Zahl interrpetiert, ordnet man diesen beiden Werten üblicherweise die Zahlen 0 und 1 zuordnen. Wie wir sehen werden, kann man es zum Beispiel auch als Vorzeichen interpretieren, und die beiden Zustände sind ">=0" und "<0".

Meist braucht man mehr als zwei verschiedene Werte, um Daten darzustellen, dann verwendet man mehrere Bits. Bei der Darstellung von Zahlen kann man mit n Bits z.B. Zahlen von 0 bis 2n-1 darstellen.

Dabei werden die n Bits als n-stellige Zahl mit der Basis 2

(Binärdarstellung, Binärzahl) interpretiert. Die Zahl mit der

Dartellung  kann also mit der

Formel

kann also mit der

Formel  berechnet werden, wobei b die Basis ist. Z.B. hat die

Binärzahl 101 den Wert

1*22+0*21+1*20=1*4+1*1=5.

berechnet werden, wobei b die Basis ist. Z.B. hat die

Binärzahl 101 den Wert

1*22+0*21+1*20=1*4+1*1=5.

In Forth können wir Zahlen in verschiedenen Basen ein- und ausgeben lassen. Einige Basen können wir direkt eingeben und direkt ausgeben:

%101 dec. #25 dec. $25 dec. %101 hex. #25 hex. $25 hex.Der Präfix

% steht für eine Binärzahl, # für

eine Dezimalzahl, und $ für eine Hexadezimalzahl (Basis

16). Die Ausgabe erfolgt bei dec. dezimal,

bei hex. hexadezimal. Für Binärausgabe gibt es kein

eigenes Wort.

Bei Eingabe von Zahlen ohne Präfix, und bei der Ausgabe

mit u. wird die aktuelle Basis verwendet. Am Anfang ist

die Basis dezimal, aber man kann sie mit n base

! ändern:

#2 base ! %101 u. $95 u. $9559 u. #9559 u. #10 base !Hier sieht man, dass die Binärdarstellung schon bei mittelgroßen Zahlen schnell unübersichtlich wird. Weiters sieht man, dass jede Hex-Ziffer in 4 Binärziffern expandiert wird (denn 24=16): $9=%1001, $5=0101. Im Gegensatz dazu ist die Umrechnung zwischen Dezimal-Darstellung und Binärdarstellung komplizierter. Daher wird in der Informatik gerne die Hexadezimaldarstellung verwendet, wenn man sich mit den Bits beschäftigen will; sie bietet einen guten Kompromiss zwischen Übersichtlichkeit und direkter Beziehung zu den Bits.

%101 dec.Zunächst werden die Zeichen bis zum ersten Leerzeichen, also

%101, als Wort aufgefasst; da es kein Wort mit

diesem Namen im Forth-System gibt, werden die Zeichen dann als Zahl

interpretiert, und diese Zahl dann auf einen Stapel

(englisch: Stack) gelegt (englisch: push, denglisch:

gepusht).

Dann wird das nächste Wort dec. angesehen; dieses wird

im Forth-System gefunden, und ausgeführt. Es nimmt eine Zahl vom

Stack und gibt sie in Dezimaldarstellung aus.

Man kann auch mehrere Werte auf den Stack legen, und dann ausgeben:

#1 #2 dec. dec.Die Werte kommen in der umgekehrten Reihenfolge der Eingabe heraus, weil 2 auf dem Stapel oberhalb von 1 zu liegen kommt, und vom ersten

dec. daher 2 vom Stapel genommen und ausgegeben

wird. Der Stack wird daher auch als last-in first-out (LIFO)

Datenstruktur bezeichnet. Das ist besonders nützlich, wenn man etwas

zwischendrin machen will, z.B.:

#3 base ! 121 #12 base ! u. #10 base !Hier wollen wir eine Zahl mit der Basis 3 eingeben und mit der Basis 12 ausgeben. Da es für Basis 3 keinen Präfix gibt, müssen wir zunächst die Basis mit

#3 base ! auf 3 setzen. Dann

folgt die Zahl 121, die wir eingeben wollen.

Um jetzt in der Basis 12 auszugeben, müssen wir die Basis

mit #12 base ! ändern. Dabei wird auch der Stack

benutzt, aber nach dem ! sind alle Spuren davon

beseitigt, und es liegt nur noch die davor eingegebene Zahl auf dem

Stack, und u. gibt diese Zahl mit der nun aktuellen Basis

12 aus.

Am Schluss schalten wir die Basis wieder auf Dezimal zurück, da es

leicht zu Fehlern führt, wenn man eine andere Basis beläßt (deswegen

empfehle ich allgemein, die Basis möglichst nicht zu ändern, sondern

mit Präfixen und hex. zu arbeiten.

Allgemeiner: es ist meist problematisch, ein Programm so zu gestalten, dass es mit einem globalen Zustand arbeitet (in diesem Fall die Basis). Bei kleinen Programmen kann man so etwas oft noch ohne große Probleme verwenden, aber wenn das Programm wächst, werden solche Techniken schnell unübersichtlich (noch schneller als der Rest).

Wenn Ihr System das Programm xterm installiert hat,

können Sie sich das

Forth-Programm status.fs holen und Gforth mit

gforth status.fsstarten. Dann wird ein Fenster geöffnet, das nach jeder Zeile die aktuelle Basis, den Inhalt des Stacks, und andere Informationen anzeigt. Allerdings müssen Sie das Fenster selbst schliessen, wenn Sie Gforth beenden.

5 4 + u.Das Wort

+ nimmt zwei Werte vom Stack, addiert sie, und

legt das Ergebnis auf den Stack. Daraus ergibt sich bei Berechnungen

eine Postfix-Notation

(der Operator ist hinter den Operanden, auch als UPN bekannt). Das

Wort * multipliziert, - subtrahiert,

und / dividiert (ganzzahlig):

5 4 * u. 5 4 - u. 7 3 / u.Interessanter wird das ganze natürlich bei Rechnungen, die man nicht so ohne weiters im Kopf ausrechnen kann:

12345 67890 * u.Man kann auch komplexere Rechnungen durchführen:

4 2 3 * + u. 4 2 + 3 * u.Wie man sieht, braucht man bei der Postfix-Notation im Gegensatz zur Infix-Notation keine Klammern und auch keine Präzendenzregeln ("Punktrechnung vor Strichrechnung") um die Reihenfolge der Auswertung festzulegen. Programmiersprachen mit Infix-Notation (wie Java) sind aber trotzdem populärer.

Warum sprechen wir davon, dass #33, $21, und %100001 nur verschiedene Darstellungen derselben Zahl sind und nicht verschiedene Zahlen? Weil sich diese Zahl mathematisch gleich verhält, egal wie sie eingegeben wurde. Z.B.:

#33 2 * u. $21 2 * u. %100001 2 * u.Dieses Prinzip, dass wir Daten verschieden darstellen können, dass sie sich aber gleich verhalten, wird uns später bei den abstrakten Datentypen noch einmal begegnen.

In der Hardware werden die Zahlen binär dargestellt, aber davon merken wir bei den bisher verwendeten Rechenoperationen normalerweise nichts. Allerdings haben die Zahlen in Forth (wie auch in den meisten anderen maschinennahen Programmiersprachen) eine begrenzte Größe, und wenn die Grenze erreicht wird, macht sich die binäre Natur schon bemerkbar:

4294967295 u. 4294967295 1 + u. 18446744073709551615 u. 18446744073709551615 1 + u.Wenn Ihr Gforth-System ein 32-bit-System ist, bewirkt schon die erste Addition einen Überlauf, bei einem 64-bit-System erst die zweite. Im Dezimalsystem sieht man den Zahlen das nicht auf den ersten Blick an, aber in der Binärdarstellung und Hexadezimaldarstellung sieht man die Besonderheit:

4294967295 #2 base ! u. #10 base ! 18446744073709551615 #2 base ! u. #10 base ! 4294967295 hex. 18446744073709551615 hex.Die Zahl besteht aus lauter Einsen, wenn man 1 dazuzählt, ergibt sich mathematisch (ohne Überlauf) die Zahl %100000000000000000000000000000000 (alias $100000000) bzw. %10000000000000000000000000000000000000000000000000000000000000000 (alias $10000000000000000), die nicht mehr in 32 Bits bzw. 64 Bits hineinpasst.

Bei arithmetischem Überlauf werden in Forth (und in den meisten maschinennahen Sprachen) die vorderen Stellen einfach abgeschnitten. Das entspricht mathematisch der Operation modulo 232 bzw. 264. Wenn man unbegrenzte Zahlen erwartet, ist dieses Verhalten unerwünscht und führt zu Fehlern, aber es kann auch nutzbringend eingesetzt werden.

0 1 - u.dann erscheint als Ausgabe die uns von vorhin bekannte größte darstellbare Zahl. Auch beim Unterlauf erfolgt die Operation modulo 2n. Wir können dieses Bitmuster aber auch als negative Zahl interpretieren:

0 1 - .Welche Interpretation wir verwenden, drücken wir in Forth dadurch aus, welches Wort wir verwenden: Wenn wir ein Bitmuster als vorzeichenlose ganze Zahl interpretieren und ausgeben wollen, verwenden wir

u., wenn wir es als vorzeichenbehaftete Zahl

interpretieren wollen, verwenden wir ..

In Forth ist es dem Programmierer überlassen, das Programm so zu schreiben, dass die Bitmuster sinnvoll interpretiert werden. Die meisten anderen Programmiersprachen haben ein Typsystem, das auf dieser Ebene eine konsistente Interpretation sicherstellt; allerdings kann das Problem auf höherer Ebene durchaus auch bei Programmiersprachen mit Typsystemen auftreten.

Äquivalenz von -1 zur größten darstellbaren vorzeichenlosen Zahl ergibt sich aus der Äquivalenz bei der Modulo-Arithmetik:

-1 = 2n-1 (mod 2n)

bzw. allgemeiner

-m = 2n-m (mod 2n)

Bei vorzeichenlosen n-Bit-Zahlen ist die kleinste klarerweise 0, und die größte 2n-1. Bei vorzeichenbehafteten Zahlen interpretiert man alle Zahlen, bei denen das höchstwertigste Bit 1 ist, als negativ, und alle, bei denen dieses Bit 0 ist, als >=0; das höchstwertige Bit wird daher auch Vorzeichen-Bit (Sign-Bit) genannt. Die kleinste vorzeichenbehaftete n-Bit-Zahl ist -2n-1, die größte 2n-1-1.

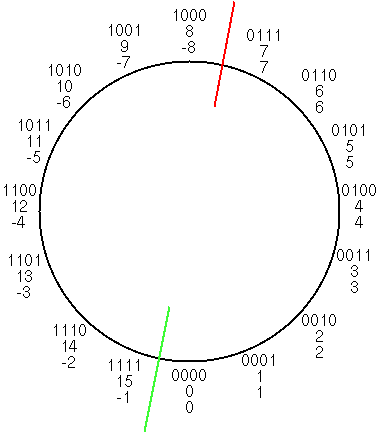

Man kann die Arithmetik modulo 2n auch als Zahlenkreis sehen. Hier ein Beispiel für 4-bit Zahlen:

Bei vorzeichenlosen Zahlen findet ein Über- oder Unterlauf statt, wenn die grüne Linie überschritten wird, bei vorzeichenbehafteten Zahlen, wenn die rote Linie überschritten wird.

Diese Darstellung der negativen Zahlen heißt Zweierkomplement-Darstellung, und die hat sich gegenüber anderen Darstellungen durchgesetzt, weil man dafür die gleichen Modulo-Arithmetik-Operationen für Addition, Subtraktion, und Multiplikation verwenden kann wie bei vorzeichenlosen Zahlen. Dementsprechend gibt es in Forth nur ein +, -, * für beide Arten von Zahlen.

Wenn wir diese Idee auf unser Dezimalsystem übertragen, dann würden wir nur Zahlen mit bis zu n Stellen darstellen und innerhalb dieser Zahlen modulo 10n rechnen; nehmen wir als Beispiel n=3, also vorzeichenlose Zahlen von 0 bis 999. Dann legen wir fest, dass wir bei der Verwendung als vorzeichenbehaftete Zahlen die Zahlen 500 bis 999 als negativ betrachten (um den eigentlichen Wert zu bekommen, müssten wir einfach 1000 abziehen, 899 würde also in konventioneller Schreibweise -101 entsprechen). Wir schreiben sie aber weiterhin als 500...999 hin, dann brauchen wir keine Sonderregeln für das Addieren, Subtrahieren, und Multiplizieren dieser Zahlen.

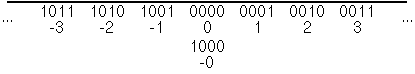

Umgekehrt können wir uns überlegen, unsere übliche Darstellung negativer Zahlen auf den Computer zu übertragen, nämlich die absolute Größe der Zahl (dargestellt wie bei vorzeichenlosen Zahlen) mit einem Vorzeichen zu kombinieren; diese Darstellung heisst sign-magnitude. Da wir auf dieser Darstellung nicht mit Modulo-Arithmetik arbeiten können, stellen wir sie als Linie und nicht als Kreis dar:

Der Nachteil dieser Darstellung ist, dass man für die Addition, Subtraktion, und Multiplikation eigene Befehle braucht, die sich von denen für vorzeichenlose Zahlen unterscheiden. Wenn Sie zum Beispiel 1001 und 0010 als sign-magnitude-Zahlen addieren, soll 0001 herauskommen, bei der vorzeichenlosen (und 2er-Komplement) Addition dagegen 1011. Auch bei anderen Operationen ergeben sich durch die Zweierkomplement-Darstellung Vorteile.

Allerdings hat die Sign-Magnitude-Darstellung, wie sie (ausserhalb von Computern) üblich ist, auch ihre Vorteile: So ist die übliche Zahlendarstellung nicht auf eine bestimmte Anzahl von Stellen festgelegt (wobei in Computern auch bei der Darstellung beliebig großer ganzer Zahlen die Zweierkomplementdarstellung dominiert).

Welche allgemeine Lehre kann man daraus ziehen: Die naheliegende Lösung ist nicht immer die beste. Andererseits: Man kann beim Abwägen verschiedener Lösungen viel Zeit verschwenden; oft ist es besser, irgendeine Lösung morgen zu haben, als die optimale Lösung in einer Woche. Es hat mehrere Jahrzehnte gedauert, bis sich die Zweierkomplementdarstellung durchgesetzt hat.

: sum-of-3 + + ; 1 2 3 sum-of-3 .Was wir noch nicht können, ist einen übergebenen Wert mehrfach zu verwenden. Wenn wir zum Beispiel eine Zahl quadrieren wollen indem wir sie mit sich selbst multiplizieren, müssen wir sie bis jetzt zwei mal hinschreiben; wenn man einen Wert viele male braucht, ist das nicht praktikabel. Stattdessen merken wir uns den Wert in einer lokalen Variable, die wir dann beliebig oft verwenden können:

: squared { n } n n * ;

5 squared .

Hier wird im Wort squared die lokale Variable n mit Hilfe

von { n } definiert, und später wird sie verwendet. Bei

der Ausführung von squared wird an der Stelle der

Definition ein Wert vom Stack genommen (und in der lokalen Variable

gespeichert). Die Verwendung von n legt diesen Wert dann auf den

Stack. Am Ende von squared verschwindet die lokale

Variable.

Betrachten wir einen kompliziereren Fall:

: squared { n } n n * ;

: foo { n } n squared squared n * ;

3 foo .

Was berechnet foo? Welchen Wert hat n an welcher Stelle? Insbesondere:

Welchen Wert hat das letzte Vorkommen von n in foo?

Squared und foo haben jeweils ihr eigenes n; tatsächlich hat sogar jeder Aufruf von squared und foo eigene Exemplare (in Informatiksprech: Instanzen) von n. Das heißt, n hat in foo den Wert 3, bei jeder Verwendung. Beim ersten Aufruf von squared hat n ebenfalls den Wert 3; dieser Aufruf legt 9 auf den Stack, und dieser Wert wird dann im zweiten Aufruf von squared in n gespeichert; n hat also im zweiten Aufruf von squared den Wert 9. Der zweite Aufruf legt 81 auf den Stack; danach wird wieder das n von foo, also 3, auf den Stack gelegt, und mit 81 multipliziert; Ergebnis: 243. Man kann sich allgemein überlegen, dass foo den Wert (n2)2*n=n5 berechnet.

Praktisch alle Programmiersprachen haben lokale Variablen, die sich so verhalten.

: bart cr ." I will not do anything bad ever again." ; : tafel 20 0 ?do bart loop ;

?do Schleifenrumpf loop nimmt zwei Werte (das

Limit, hier 20, und der Startwert, hier 0) vom Stack und

führt Schleifenrumpf d mal aus, wobei d die

Differenz der beiden Werte ist.

Dabei kann man mit i den Schleifenzähler abfragen:

: test ?do i . loop ; 10 0 test 5 3 testBeim ersten Durchlauf (Iteration) ist der Schleifenzähler gleich dem Startwert, wenn das Limit erreicht ist, wird die Schleife nicht mehr durchlaufen.

I verhält sich dabei ähnlich wie eine

lokale Variable (auch wenn es einige Unterschiede gibt). Hier eine

Anwendung:

: fac { n } n n 1 ?do i * loop ;

5 fac .

Wobei dieses Programm verständlicher wird, wenn man es etwas

umformattiert und etwas dokumentiert:

: fac { n -- n! }

n

n 1 ?do ( n1 )

i *

loop ;

5 fac .

In diesem Programm ist im Gegensatz zu den bisherigen der Stack nicht

leer, wenn ein Schleifendurchlauf beginnt und endet, was das

Verständnis etwas erschwert. Daher dokumentieren wir den Inhalt des

Stack am Anfang eines Durchlaufs mit dem Kommentar ( n1

).

Und wenn wir schon dabei sind, dokumentieren wir auch noch den

Stack-Effekt der gesamten Definition. Traditionell macht man

das in Forth mit Kommentaren wie ( n -- n! ) (mit runden

Klammern); vor -- schreibt man die Stack-Elemente, die

das Wort vom Stack nimmt, hinter -- die Stack-Elemente,

die das Wort auf den Stack legt.

Da die Definition von lokalen Variablen oft am Anfang der

Wort-Definition erfolgt, kann man diese Definition auch als

Stack-Effekt hinschreiben: { n -- n! } (mit

geschwungenen Klammern im Gegensatz zu runden), wobei --

n! ignoriert wird.

Die Zeilenumbrüche und Einrückungen sollen die Kontrollstruktur deutlich machen. Dabei hat man in der Formattierung in Forth wie in den meisten Sprachen große Freiheiten, die praktisch immer so genutzt werden, und das ist auch sehr empfehlenswert. Einige Programmiersprachen (z.B. Python) verlangen sogar so eine Einrückung, um den Geltungsbereich der Kontrollstruktur festzulegen.

5 3 < . -5 -3 < . 5 3 u< . -5 3 u< . 3 3 = .Vergleiche liefern in Forth 0 für "falsch" und -1 für "wahr". Man kann auf der Grundlage von Vergleichen unterschiedliche Wörter ausführen:

: max { a b -- c }

a b < if

b

else

a

endif ;

3 5 max .

-3 -5 max .

: abs { n -- n1 }

n

n 0 < if ( n )

negate

endif ;

3 abs .

-3 abs .

if then-Zweig else else-Zweig endif nimmt einen

Wert vom Stack. Ist er 0, wird else-Zweig

bzw. bei Nichtvorhandensein einer else-Klausel gar nichts

ausgeführt, ansonsten then-Zweig (so genannt, weil bei

manchen Sprachen dort ein then steht, wo in Forth

das if steht). Anschliessend fährt die Ausführung hinter

dem endif fort.

negate hat den Stack-Effekt ( n -- -n ).

Wenn, wie hier, mehrere lokale Variablen in einer Definition definiert werden, erhaelt die rechteste definierte lokale Variable den obersten Wert auf dem Stack, die nächste von rechts den nächsten Wert auf dem Stack, usw.

: digits ( n -- )

begin { n }

n while

n 10 mod .

n 10 /

repeat ;

1234 digits

[Hier werden die Ziffern in der umgekehrten Reihenfolge ausgegeben wie

gewöhnlich, und wir verwenden ein Wort zur Ausgabe der Ziffern, das

selbst die komplette Umwandlung machen kann; wir werden diese Makel

später beheben.]

Eine begin Rumpf1 while Rumpf2

repeat Schleife führt zunächst Rumpf1 aus.

Das while nimmt einen Wert vom Stack; ist er 0

(Abbruchbedingung), wird die Ausführung der Schleife

hinter repeat fortgesetzt; ansonsten

wird Rumpf2 ausgeführt, und dann beginnt die Ausführung der

Schleife von vorne.

mod ( n1 n2 -- n3 ) berechnet den Rest der Division

von n1 durch n2 (Modul).

digits übergibt.

Bei einem negativem Parameter ist das allerdings nicht der Fall:

Gforth rundet bei der ganzzahligen Division in Richtung

-∞. -1 10 / ergibt -1, und alle negativen Zahlen

erreichen bei wiederholter Division durch 10 irgendwann -1, und

daraufhin wiederholt sich die Schleife endlos (Abbruch in Gforth mit

Ctrl-C).

Um digits also so aufzurufen, dass es terminiert, muss

der Wert auf dem Stack also ≥0 sein. Das ist

die Vorbedingung für die Schleife und

für digits. Wir werden uns später noch eingehender mit

Vorbedingungen beschäftigen.

Termination ist in der theoretischen Informatik ein wichtiges Thema: Man kann kein Programm schreiben, das von einem beliebigen Programm feststellt, ob es terminiert oder nicht (Entscheidbarkeit).

In der Praxis ist Termination aber normalerweise kein großes Problem; die Fälle, die in der Theorie Schwierigkeiten machen, vermeidet man im Normalfall, und in den meisten Fällen ist es recht einfach, festzustellen, dass man sich der Abbruchbedingung nähert (der Fall oben ist schon relativ kompliziert). Dass der Rest der Schleife das tut, was man gerne hätte, ist in den meisten Fällen schwieriger hinzubekommen.

Aber auch wenn es nicht sehr schwer ist, muss man es trotzdem machen, zum Beispiel beim Test; auch wenn Sie die Aufgabe nicht komplett hinbekommen, werden Sie für eine Schleife, die endet, mehr Punkte bekommen als für eine Endlosschleife, zumindest wenn die Schleife mit der Problemstellung zu tun hat.

Es ist nicht offensichtlich, wohin sich die Folge entwickelt. Wir könnten das jetzt per Hand für ein paar Werte von x0 ausrechnen, aber das ist auf die Dauer etwas langwierig, also schreiben wir ein Programm dafür. Zunächst die Berechnung des nächsten Elements der Folge:

: step { xn -- xn1 }

xn 2 mod 0 = if

xn 2 /

else

xn 3 * 1 +

endif ;

13 step .

Jetzt können wir uns mit einer Zählschleife eine feste Anzahl von

Werten der Folge anzeigen lassen:

: steps ( x0 k -- )

0 ?do { xn }

xn .

xn step

loop drop ;

13 20 steps

9 20 steps

7 20 steps

Es schaut so aus, als ob die Folge bei x0≥1 irgendwann

den Zyklus 4 2 1 erreicht. Ist dieser Zyklus erreicht, so bleibt die

Folge in dem Zyklus. Wir können jetzt eine allgemeine Schleife

schreiben, die sich so lange wiederholt, bis 1 erreicht ist:

: steps-to-1 ( x0 -- )

begin { xn }

xn 1 <> while

xn .

xn step

repeat ;

7 steps-to-1

Das ist möglicherweise eine Endlosschleife; wir wissen ja nicht, ob

jede Folge irgendwann 1 erreicht. Aber da der Zweck dieses Programms

die Erkundung ist und nicht das Lösen eines gegebenen Problems, ist

das hier akzeptabel.

Üblicherweise betrachtet man das Verhalten zur Laufzeit, indem man einfach die Schritte des Programms durchgeht; "Debugger" verfügen üblicherweise über eine Step-Funktion, die einem dabei unterstützt (von deren Verwendung ich aber in den meisten Fällen abrate, weil es wesentlich effektivere Methoden gibt, um Fehler zu lokalisieren).

Aber man kann die ausgeführten Schritte auch hinschreiben, und erhält so einen Trace.

Als einfaches Beispiel betrachten wir einen Trace zu einem einfachen Programm:

: bla 1 - 3 * ; : blub 2 * bla 3 bla + ;Der Trace für

5 blub . ist:

5 2 * 1 - 3 * 3 1 - 3 * + .In diesem Trace und in den folgenden ist der Kontrollfluss (z.B. Aufrufe und die Rückkehr von Aufrufen) weggelassen, da der ja schon in den im Trace vorkommenden Worten widergespiegelt ist.

Betrachten wir als nächstes Beispiel:

: squared { n } n n * ;

: foo { n } n squared squared n * ;

3 foo .

Hier stellen wir den Anfang und das Ende des Sichtbarkeitsbereichs von

lokalen Variablen (der hier mit den Aufrufem und der Rückkehr von den

Aufrufen übereinstimmt) mit ( ) dar, weil das nötig ist,

um zu erkennen, welche Verwendung von n zu welcher Definition gehört.

3 ( { n } n ( { n } n n * ) ( { n } n n * ) n * ) .

Leider kann man diese Sequenz nicht direkt in Forth verarbeiten, weil

lokale Variablen nur in Definitionen funktionieren (und die Klammern

in Forth eine andere Bedeutung haben). Wir können die lokalen

Variablen auch auflösen, dann erhalten wir eine ausführbare Sequenz:

3 ( { n } n ( { n } n n * ) ( { n } n n * ) n * ) .

3 drop 3 drop 3 3 * drop 9 9 * 3 * .

Drop entfernt das oberste Element des Stacks.

Etwas interessanter wird das Ganze, wenn Kontrollstrukturen in's Spiel kommen:

13 steps-to-1 4 steps-to-1Wir zeigen im folgenden die Kontrollflusswörtern

if

while, weil sie neben ihrer Kontrollflussfunktion einen Wert

vom Stack nehmen (was im Trace äquivalent zu drop ist).

13

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 3 * 1 + ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 3 * 1 + ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while )

.

4

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while n . n ( { n } n 2 mod 0 = if n 2 / ) )

( { n } n 1 <> while )

.

Hier sehen, wir, dass ein Programm zur Laufzeit meist verschiedene

Abläufe abhängig von der Eingabe hat, und dass schon kurze Läufe viele

Schritte ausführen können. Ein Fehler kann in einem Lauf (mit einer

Eingabe) auftreten und in einem anderen (mit anderer Eingabe) nicht.

Es ist daher oft nicht zielführend, über ein Programm nur anhand eines konkreten Laufs bzw. Traces nachzudenken.

Daher sollte man zusätzlich von diesen verschiedenen Abläufen abstrahieren und gemeinsame Eigenschaften über alle Läufe erkennen. Bzw. umgekehrt das Programm so schreiben, dass man mit einer Beschreibung wichtige Eigenschaften aller Läufe erfasst.

Die Repräsentation des Programms über alle Abläufe ist der Text des Programms (auch Quelltext, Quellcode oder Source code genannt), daher geht man bei solchen Beschreibungen mit dem Programmtext. Da der Programmtext feststeht, nennt man so eine Beschreibung statisch, während eine Betrachtung, die sich auf einen konkreten Lauf bzw. Eigenschaften zur Laufzeit bezieht, dynamisch genannt wird. Im folgenden sehen wir einige Beispiele, und das Thema wird uns auch im Rest des Semesters begleiten.

In Forth ist es zum Beispiel im Prinzip möglich, dass ein Wort zur Laufzeit einen beliebigen, stark von den Eingabedaten abhängigen Stack-Effekt hat (also einen dynamischen Stack-Effekt). Allerdings kann man solche Wörter nicht vernünftig einsetzen und Programme mit solchen Wörtern nur schwer, wenn überhaupt, verstehen. Daher sind solche Wörter und Programme in Forth unüblich. Die Stack-Tiefe ist normalerweise an einer bestimmten Stelle immer gleich, egal auf welchem Weg diese Stelle erreicht wurde; und selbst bei den wenigen Ausnahmen davon kommen nur Dinge vor, die man auf einer höheren Ebene wieder statisch verstehen kann.

Das spiegelt sich auch in der Dokumentation wieder:

: fac { n -- n! }

n

n 1 ?do ( n1 )

i *

loop ;

5 fac .

Hier sagt der Kommentar ( n1 ), dass an dieser Stelle

genau ein Element über dem Grundniveau auf dem Stack liegt, egal mit

welchem Parameter fac aufgerufen wird und wie oft die

Schleife durchlaufen wird (das Grundniveau sind die Elemente auf dem

Stack, die von fac nicht berührt werden sollen, die also unter dem

Parameter n auf dem Stack liegen).

Man kann das auch an den anderen Beispielen sehen, die wir bisher gesehen haben:

Bei Schleifen ist der Rumpf so gestaltet, dass die

Stacktiefe am Anfang und am Ende des Rumpfs gleich sind. Wenn man

einen Wert auf dem Stack bearbeiten will, muss man ihn schon vor der

Schleife drauflegen, wie bei fac geschehen, und

ggf. nachher wieder entfernen.

Bei bedingter Ausführung muss der then-Zweig den selben Effekt auf die Stack-Tiefe haben wie der else-Zweig. Wenn es keinen else-Zweig gibt, darf der then-Zweig die Tiefe nicht ändern.

Betrachten wir als Beispiel

: abs { n -- n1 }

n

n 0 < if ( n )

negate

endif ;

Hier haben wir einen then-Zweig, der die Stack-Tiefe nicht ändert,

dafür mussten wir das eventuell negierte n schon deutlich früher auf

den Stack legen. Eine andere Lösung wäre:

: abs { n -- n1 }

n 0 < if ( n )

n negate

else

n

endif ;

Da hier im then-Zweig etwas auf den Stack gelegt wird, brauchen wir

auch einen else-Zweig, der etwas auf den Stack legt. Falsch wäre:

: abs { n -- n1 } \ falsch!

n 0 < if

n negate

endif ;

Allerdings merken Sie diesen Fehler in Forth erst beim Testen:

-5 abs . 5 abs .

Die Stack-Tiefe ist nur ein Beispiel. Auch wenn die meisten anderen Programmiersprachen keinen expliziten Stack haben und diese spezielle Eigenschaft dort keine Rolle spielt, es gibt immer eine Menge Eigenschaften, die man statisch verstehen möchte, und wir werden noch weitere Beispiele sehen.

Schauen wir uns noch einmal unser fac-Beispiel an:

: fac { n -- n! }

n

n 1 ?do ( n1 ) \ n1 = (i-1)!*n

i * ( n2 ) \ n2 = i!*n

loop ( n3 ) \ n3 = (n-1)!*n = n!

;

Hier haben wir Kommentare wie ( n2 ) \ n2 = i!*n

geschrieben.

Den ersten Teil ( n2 ) haben wir schon besprochen.

Dieses sogenannte Stack-Bild kann man auch als Invariante über die

Stack-Elemente sehen.

Der Kommentar dahinter, der mit

\ eingeleitet wird, ist eine Invariante bezüglich des

Wertes von n2.

Betrachten wir noch einmal das Wort fac. Wie bin ich

dazu gekommen, und gibt es noch andere Möglichkeiten?

Fangen wir mit der mathematischen Formel an:

n!=1*2*3*...*n

In Postfix-Syntax ist das:

1 2 * 3 * ... n *

Das kann man jetzt als gewünschten Trace auffassen. Die

aufsteigende Folge von Zahlen legt die Verwendung einer Zählschleife

nahe, wobei die Zahlen direkt über den Zähler i generiert werden

können. Dann hätten wir also den Schleifenrumpf i *

bzw. die Schleife (ohne Parameter):

?do i * loopIm Schleifenrumpf legt

i ein Element auf den

Stack, * nimmt 2 Elemente vom Stack und legt wieder eines

drauf. Die Stacktiefe ändert sich also im Schleifenrumpf nicht, in

dieser Hinsicht ist die Schleife schon einmal in Ordnung. Allerdings

muss schon vor dem Schleifenrumpf ein Element auf dem Stack liegen,

was wir mit einem Stack-Bild ausdrücken:

?do ( n1 ) i * loopWenn wir

i von 2 bis n gehen lassen wollen, dann müssen

wir die Schleifenparameter so hinschreiben:

: fac { n -- n! }

...

n 1 + 2 ?do ( n1 )

i *

loop

... ;

Aus der obigen Postfix-Formel haben wir "1" noch nicht in dem Programm

untergebracht, das ist ein naheliegender erster Wert für n1:

: fac { n -- n! }

1

n 1 + 2 ?do ( n1 )

i *

loop

... ;

Müssen wir noch etwas machen? Überlegen wir uns

Schleifeninvarianten:

: fac { n -- n! }

1

n 1 + 2 ?do ( n1 ) \ n1 = 1*2*..*(i-1)=(i-1)!

i * ( n2 ) \ n2 = 1*2*..*i = i!

loop ;

Da der letzte Wert von i=n ist, haben wir am Ende n! auf dem Stack,

wir brauchen also nichts weiter machen.

Allerdings ist die Vorbedingung dieser Schleife n≥1, da sonst

die Grenze der Zählschleife kleiner ist als der Startwert. Wir können

den Startwert allerdings auch auf 1 setzen. Das bewirkt in den

meisten Fällen einen zusätzlichen Schleifendurchlauf, der 1

* bewirkt, was auf das Ergebnis keinen Einfluss hat. Im Fall

n=0 sorgt er dafür, dass die Schleife nicht ausgeführt wird und das

Ergebnis gleich 1 ist (entsprechend 0!=1, wie in der Methematik

definiert):

: fac { n -- n! }

1

n 1 + 1 ?do ( n1 ) \ n1 = 1*1*2*..*(i-1)=(i-1)!

i * ( n2 ) \ n2 = 1*1*2*..*i = i!

loop ;

Früher haben wir die folgende Variante gesehen:

: fac { n -- n! }

n

n 1 ?do ( n1 ) \ n1 = (i-1)!*n

i * ( n2 ) \ n2 = i!*n

loop ( n3 ) \ n3 = (n-1)!*n = n!

;

Hier wird die Multiplikation mit n in der Schleife eliminiert, indem

wir am Anfang n statt 1 auf den Stack legen. Man erspart sich dadurch

das 1 + beim Berechnen der Schleifenparameter.

Allerdings hat diese Variante auch n≥1 als Vorbedingung.

Auf diese Schleife bin ich gekommen, indem ich mir wie oben den Schleifenrumpf überlegt habe. Bei den Schleifenparametern bin ich zunächst von n 0 ausgegangen, denn das ist für Zählschleifen der Normalfall in Forth; allerdings würde das f0*0*1*..*(n-1) ergeben (f0 ist Anfangswert), wobei 0 schon einmal unerwünscht ist. Das habe ich korrigiert, indem ich n 1 als Schleifenparameter gewählt habe, macht f0*1*..*(n-1)=f0*(n-1)!. Dann kam die Idee, dass ich mit f0=n zu meinem gewünschten Resultat käme. Den Fall n=0 habe ich mir dabei offensichtlich nicht überlegt; Fehler an den Grenzen des Eingabebereichs sind übrigens häufig.

Das geht für Programme mit mathematischer Aufgabenstellung wie unser fac-Beispiel recht gut; im Allgemeinen ist es aber sehr aufwendig, ein größeres Programm formal zu spezifizieren, und dann die Übereinstimmung des Programms mit der Spezifikation zu beweisen.

Und dabei ist die Frage: Beschreibt die formale Spezifikation das, was wir von dem Programm erwarten? Auch in der Spezifikation können Fehler vorkommen.

Es gibt durchaus einige Bereiche, in denen formale Methoden erfolgreich verwendet werden, aber meistens überprüft man damit nur einen Teil der Eigenschaften, die wir vom Programm erwarten, und zwar die, die mit formalen Methoden gut und verständlich spezifiziert und überprüft werden können, und die mit anderen Methoden schlecht zu überprüfen sind. Ein berühmtes Beispiel ist die Überprüfung von Windows-Treibern auf Fehler durch gleichzeitige Ausführung (z.B. auf mehreren Kernen eines Multi-Core-Prozessors); Microsoft stellt ein Werkzeug zur Verfügung, um die Abwesenheit solcher Fehler formal zu beweisen. Das beweist noch nicht, dass der Treiber funktioniert wie erwartet, aber immerhin, dass er eine bestimmte Art von Fehler nicht hat.

Wir können weitere Eingaben verwenden und die Ausgaben für diese Eingaben prüfen (weitere Testfälle), und können so das Vertrauen in die Korrektheit des Programmes steigern.

Ein großer Vorteil solcher Testfälle ist, dass sie (im Vergleich zu einer formalen spezifikation) relativ leicht verständlich sind, und es daher seltener vorkommt, dass der Testfall von dem abweicht, was man vom Programm erwartet.

Damit das möglichst effektiv geschieht, sollte man aber nicht einfach irgendwelche Testfälle verwenden, sondern mit System vorgehen.

Ein Grundsatz dabei ist, die Testfälle alle Teile des Codes einmal ausführen sollten (Coverage). Ein Testfall kann einen Fehler in einem Stück Code ja nur dann finden, wenn er es ausführt.

Unser fehlerhaftes abs-Beispiel zeigt, dass das nicht reicht:

: abs { n -- n1 } \ falsch!

n 0 < if

n negate

endif ;

-5 abs . .s

Hier führt der Testfall jedes Wort in abs aus (statement

coverage), trotzdem wird der Fehler nicht gefunden. Man muss

also auch Testfälle haben, die Zweige ausführen, die keinen Code

enthalten (branch coverage), in diesem Fall mit "5 abs

.". Es gibt auch noch

weitere Coverage-Kriterien,

auf die wir hier aber nicht weiter eingehen.

Bei komplexeren Programmen ist es übrigens oft schwierig, 100% Coverage zu erreichen, da ein Teil des Codes für die Behandlung von Fehlern da ist, die normalerweise nicht auftreten (z.B. ein Fehler durch eine kaputte Festplatte), oder nach der aktuellen Programmlogik gar nicht auftreten können (aber möglicherweise nach Änderungen im Programm schon).

Eine häufige Fehlerquelle ist, bei Abfragen für Schleifenenden oder

bedingungte Ausführung auf z.B. n statt auf n+1 oder n-1 abzufragen,

oder > statt >= zu schreiben oder

umgekehrt. Auf diese sogenannten off-by-one-Fehler können

Sie testen, indem Sie die Testfälle so gestalten, dass sie in dem

Bereich, in dem die Verzweigung in die andere Richtung ausfallen

würde, eben genau die beiden Grenzwerte abtestet. Bei

unserem abs-Beispiel wären das die Testfälle:

0 abs . .s -1 abs . .sDa der 0-Fall in diesem Fall nicht besonders aussagekräftig ist, würde ich auch noch

1 abs . .shinzufügen.

Wenn wir das fac-Beispiel betrachten, und ein Wort

haben wollen, das auch 0! korrekt berechnet, dann ist ein guter Testfall

0 fac . .sDer würde unsere beiden Implementierungen mit der Vorbedingung n≥1 sofort als "nicht der Anforderung entsprechend" entlarven. Weitere Testfälle für

fac wären:

1 fac . .s \ weiterer off-by-one Test 3 fac . .s \ passt die Multiplikation?

Man kann die Testfälle auch unabhängig von dem Code schreiben, den man testen will (black box testing); solche Tests sollten dann für alle möglichen Programme verwendbar sein, die die Anforderungen erfüllen. Teilweise werden sogar die Tests als (partielle) Spezifikation der Anforderungen entwickelt und vor dem Programm geschrieben (Test-Driven Development).

Da man Black-Box-Tests nicht auf die konkrete Programmstruktur

abstellen kann, hat man weniger Orientierung, was man Testen soll.

Aber man kann sich an Grenzwerten in der Spezifikation bzw. in den

Anforderungen orientieren; diese werden wohl auch zu Verzweigungen im

Code führen, und dort kann man dann Testfälle um diese Grenzwerte

herumgruppieren. Bei abs kommen wir dabei auf die

gleichen Testfälle.

Bisher haben wir bei den Tests nur die Eingabe spezifiziert, und die Ausgabe dann mit unseren Augen überprüft. Das ist unpraktisch, wenn man die Tests mehrfach durchführen will oder unabhängig von den Programmen den kompletten Testfall hinschreiben will (was besonders beim Black-box-Testen vorkommt). Daher gibt es auch Möglichkeiten, die Ausgabe eines Tests zu spezifizieren. Wenn Sie Gforth mit

gforth test/ttester.fsstarten, dann steht ihnen so ein Werkzeug zur Verfügung, wobei Ausgaben auf dem Stack überprüft werden:

t{ -1 abs -> 1 }t

t{ 0 abs -> 1 }t

t{ 1 abs -> 1 }t

Da auch Testen die Korrektheit nicht beweist, kombiniert man es am besten mit anderen Methoden, um Fehler zu finden. Eine gute Ergänzung zum Testen ist Code Review, wo man den Programmcode mit jemandem zusammen durchgeht, der ihn nicht geschrieben hat.

In der Lehrveranstaltung Übersetzerbau bewerte ich die abgegebenen Programme in erster Linie mit (Black-Box-)Tests. Zusätzlich kommt es zu einem Gespräch, indem die Studentinnen und Studenten die von ihnen abgegebenen Programme erklären müssen. Oft entdecke ich dabei noch Fehler, die durch die Testfälle nicht aufgedeckt wurden.

Jedes Byte kann einzeln angesprochen werden, es hat eine Adresse, die natürlich auch wieder ein Bitmuster ist, das man üblicherweise als vorzeichenlose Zahl interpretiert und oft in Hexadezimaldarstellung hinschreibt.

Ein Programm, das auf einem Betriebssystem mit Speicherschutz (wie

Linux, Windows, oder MacOS X) läuft, kann nicht auf jede beliebige

Adresse zugreifen, sondern nur auf Speicherbereiche, die das

Betriebssystem dem Programm zur Verfügung stellt. In Forth können Sie

mit dem Wort c@ ( addr -- c ) (ausgesprochen "C-Fetch")

das Byte c von der Adresse addr lesen. Probieren wir das einmal an

irgendeiner Stelle:

1234 c@ .Wenn Ihr Betriebssystem dem Forth-System nicht zufällig den Speicher an der Adresse 1234 zur Verfügung stellt, sehen Sie eine Fehlermeldung wie

:1: Invalid memory address 1234 >>>c@<<< . Backtrace:Dann hat der Speicherschutz zugeschlagen; in diesem Fall wurde der Fehler vom Forth-System abgefangen; wenn ein Programm so einen Fehler nicht abfängt, produziert das Betriebssystem eine Fehlermeldung wie "Segmentation fault" (Unix) oder "General protection fault" bzw. "Allgemeine Schutzverletzung" (Windows).

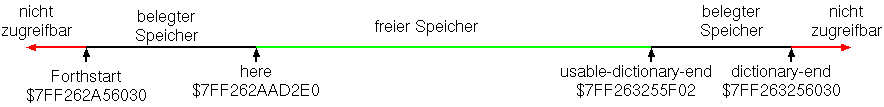

Auf welchen Speicher können wir jetzt zugreifen? In Forth gibt es einen großen Speicherbereich namens "Dictionary":

Die konkreten Zahlenwerte für die Adressen variieren von System zu System und sind hier nur beispielhaft angegeben. Wir können uns jetzt die Bytes in diesem Speicherbereich anschauen, z.B.:

forthstart c@ . forthstart 1 + c@ .

Das wird auf die Dauer etwas mühsam, aber wir können ja ein Wort

schreiben, das uns das ganze etwas erleichtert. Da so ein Wort öfters

benötigt wird, gibt es schon so eines in Forth: dump ( addr u --

) zeigt das Byte an Adresse addr und die folgenden, insgesamt u

Bytes (also bis inklusive addr+u-1). Beispiel (mit Ausgabe):

forthstart 80 dump 7FF262A56030: 30 60 A5 62 F2 7F 00 00 - 65 87 CB BD 52 37 C8 2B 0`.b....e...R7.+ 7FF262A56040: B0 72 05 00 00 00 00 00 - 00 00 80 00 00 00 00 00 .r.............. 7FF262A56050: 00 40 00 00 00 00 00 00 - 00 40 00 00 00 00 00 00 .@.......@...... 7FF262A56060: 00 3C 00 00 00 00 00 00 - 00 3A 00 00 00 00 00 00 .<.......:...... 7FF262A56070: 80 06 A6 62 F2 7F 00 00 - D0 E7 A6 62 F2 7F 00 00 ...b.......b....

Dump zeigt in jeder Zeile die Adresse des ersten Bytes

der Zeile an (als Hex-Zahl), und danach 16 Bytes auf zwei Arten an:

als Hex-Zahl, und, wenn es ein anzeigbares ASCII-Zeichen ist, als

Zeichen (sonst als .). Wir sehen also im dump, dass an Adresse

$7FF262A56030 das Byte $30 steht, was der ASCII-Code für das Zeichen

"0" ist; an der nächsten Adresse $7FF262A56031 steht das Byte $60, als

Zeichen "`"; usw.

Der Speicherbereich heißt deswegen Dictionary, weil dort die

Forth-Wörter gespeichert sind. Wenn wir ein Wort dazufügen, wird es

am Anfang des bisher freien Speichers gespeichert,

und here verschiebt sich:

here here : bart cr ." I will not do anything bad ever again." ; here cr .s - negate dump <3> 140141316031200 140141316031200 140141316031368 7F75315C42E0: D8 27 5C 31 75 7F 00 00 - 04 00 00 00 00 00 00 80 .'\1u........... 7F75315C42F0: 62 61 72 74 20 20 20 20 - AA 43 40 00 00 00 00 00 bart .C@..... 7F75315C4300: 00 00 00 00 00 00 00 00 - F8 44 40 00 00 00 00 00 .........D@..... 7F75315C4310: D8 22 57 31 75 7F 00 00 - 1B 46 40 00 00 00 00 00 ."W1u....F@..... 7F75315C4320: 50 43 5C 31 75 7F 00 00 - 49 20 77 69 6C 6C 20 6E PC\1u...I will n 7F75315C4330: 6F 74 20 64 6F 20 61 6E - 79 74 68 69 6E 67 20 62 ot do anything b 7F75315C4340: 61 64 20 65 76 65 72 20 - 61 67 61 69 6E 2E 20 20 ad ever again. 7F75315C4350: 68 4D 40 00 00 00 00 00 - 28 43 5C 31 75 7F 00 00 hM@.....(C\1u... 7F75315C4360: 68 4D 40 00 00 00 00 00 - 26 00 00 00 00 00 00 00 hM@.....&....... 7F75315C4370: A0 45 40 00 00 00 00 00 - 88 1F 57 31 75 7F 00 00 .E@.......W1u... 7F75315C4380: 5B 45 40 00 00 00 00 00 - [E@.....Hier sehen wir den Speicher, der vom Wort

bart belegt

wird. Zu erkennen ist dabei der Name des Wortes, und der Text, den

das Wort ausgibt, der Rest besteht aus Verwaltungsinformation für das

Forth-System und aus einer anderen Repräsentation des Programmcodes.

Hier sehen wir schon, dass der Quellcode normalerweise nicht direkt

ausgeführt wird, sondern entweder in Maschinensprache übersetzt

(compiliert) wird, oder zumindest (wie hier) in eine Form,

die relativ schnell ausgeführt werden kann.

Als nächstes wollen wir unseren eigenen Speicherbereich reservieren, in dem wir tun und lassen können, was wir wollen:

here 10 allot constant aHier reservieren wir uns 10 Bytes mit mit

allot ( u -- ),

und speichern die Anfangsadresse dieses Speicherbereichs in einer

Konstante a. Dabei darf die Definition von a erst nach

dem allot erfolgen, da constant ja selbst

Speicher im Dictionary reserviert und here weiterbewegt:

a here a - dumpWir können jetzt Bytes in diesen Bereich schreiben:

$25 a c! $35 a 1 + c! $45 a 2 + c!... und von dort wieder auslesen:

a 1 + c@ hex.bzw. den Speicherbereich anschauen:

a 10 dump

c! (ausgesprochen "C-Store") hat den Stack-Effekt (

c addr -- ) und schreibt das Byte c an die Adresse addr.

c@)

addressieren zu können, ist man bei PCs seit 2003 und bei Smartphones

seit 2013 auf 64-bit-Maschinen umgestiegen, mit denen Adressräume bis

zu 16 EB (oder 4 Milliarden mal groesser als bei 32-bit-Maschinen)

möglich ist.

Die Größe der Adressen bestimmt auch die Größe der effizient verarbeitbaren ganzen Zahlen, da mit den Adressen auch gerechnet wird, wie wir sehen werden. Diese Größe nennt man in der Computerarchitektur auch die Wortgröße. Allerdings hat "Wort" in Forth eine andere Bedeutung, daher verwenden wir in Forth stattdessen der Begriff Zelle (cell).

[Leider wird "Wort" bzw. "word" auch in den Assemblerhandbüchern diverser Prozessorhersteller anders verwendet: Es bezeichnet die Adressgröße des Urahns einer Familie von Prozessoren; so verwendet Intel (dominant bei PCs) auch auf 64-bit-Prozessoren "Word" für 16 bits, weil der Urahn 8008 Adressen in 16 bits speicherte, während ARM (dominant bei Smartphones) "Word" für 32 bits verwendet.]

Auf Gforth ist die Zellengröße 64 bits oder 32 bits (wobei der Windows-Port derzeit ein 32-bit-Programm ist; das läuft auch auf 64-bit-Versionen von Windows, hat aber 32-bit-Zellen und daher nur 4GB Adressraum). Sie können sich die Zellengrösse in Bytes mit

1 cells .anzeigen lassen.

cells ( n1 -- n2 ) multipliziert den

Wert auf dem Stack mit der Anzahl der Bytes pro Zelle. Wenn wir also

z.B. Speicher für 10 Zellen reservieren wollen, können wir das so

machen:

here 10 cells allot constant bJetzt können wir eine Zelle am Anfang dieses Bereichs speichern:

$1234567890abcdef b ! b 1 cells dump

! ( x addr -- ) ("Store") speichert x an die Stelle addr.

Der Dump auf meinem Computer::

7F702E2D72E0: EF CD AB 90 78 56 34 12 - ....xV4.Wenig überraschend benötigt die Speicherung mehrere Bytes, und zwar auf diesem 64-bit-System 8 Bytes. Das niederwertigste Byte wird an der niedrigsten Adresse gespeichert, und das höchstwertige an der höchsten. Diese Speicherung heißt little-endian. Wenn wir einen andere Wert in unserem Speicherbereich speichern wollen, ohne den ersten zu zerstören, müessen wir frühestens 8 Bytes, also eine Zelle, später beginnen:

$fedcba0987654321 b 1 cells + ! b 2 cells dump b @ hex.

@ ( addr -- x ) ("Fetch") liest die Zelle an der Adresse

addr und legt den Inhalt auf den Stack. Wenn wir dagegen versuchen

würden, den zweiten Wert an der Adresse b 1 + zu

speichern, würde der erste Wert teilweise Überschrieben:

$1111111111111111 b 1 + ! b 2 cells dump b @ hex.[Manche Prozessoren können nur auf durch die Zellengröße teilbare Adressen zellenweise zugreifen (Ausrichtung oder Alignment) und liefern in diesem Fall einen Fehler.]

Wenn wir ein Array A von Zellen haben und auf einen Index k zugreifen möchten, geht das einfach mit

A k cells + @ ( x ) \ Lesen

( x ) A k cells + ! \ Schreiben

Bei einem Array B von Bytes geht es noch etwas einfacher:

B k + c@ ( c ) \ Lesen

( c ) B k + c! \ Schreiben

Wobei der Index dabei jeweils bei 0 anfängt; bei einem Array der Größe

n ist der maximale Index n-1. Wenn wir ein Array mit kleinstem

Index l haben wollen, muss man den Zugriff etwas abwandeln:

A k l - cells + \ und jetzt @ oder ! B k l - + \ und jetzt c@ oder c!Dabei wird nicht überprüft, ob der Index im vorgesehenen Bereich ist; das muss der Programmierer auf andere Weise sicherstellen. Versäumnisse in dieser Hinsicht sind eine häufige Fehlerquelle und auch eine häufige Sicherheitslücke (insbesondere buffer overflow attack). Höherlevelige Programmiersprachen wie Java überprüfen allerdings den Index beim Arrayzugriff, ein Zugriff ausserhalb des Arrays kann daher dort nicht vorkommen.

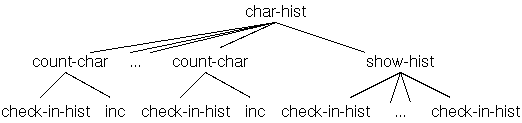

32 constant hl \ lower index

127 constant hu \ upper index+1

here hu hl - cells allot constant hist

: inc { addr -- }

addr @ 1 + addr ! ;

: count-char { c -- }

c hl >= if

c hu < if

hist c hl - cells + inc

endif

endif ;

: show-hist ( -- )

hu hl ?do

cr hist i hl - cells + @ .

i emit

loop ;

: count-chars { addr u -- }

addr u + addr ?do

i c@ count-char

loop ;

: char-hist { addr u -- }

hist hu hl - cells erase \ hist loeschen

addr u count-chars

show-hist ;

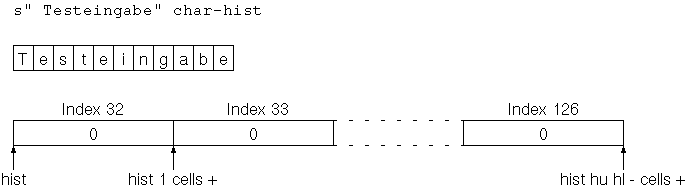

Dabei gibt emit ( c -- ) einen Wert als (ASCII-)Zeichen aus.

Wir können dieses Programm mit einer Eingabe wie

s" Testeingabe" char-histtesten, wobei

S" den Text bis zum " als

Zeichen-Array (String) abspeichert und die Adresse und Länge des

Arrays ( addr u ) auf den Stack legt. Dieses Array, und

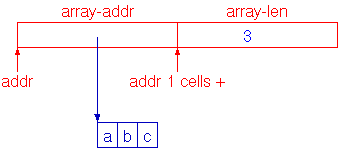

das Array hist sind in folgender Grafik dargestellt:

Als interessantere Eingabe kann man eine ganze Datei verwenden:

s" slides.tex" slurp-file char-hist

slurp-file ( addr1 u1 -- addr2 u2 ) liest den Inhalt der

Datei mit dem durch addr1 u1 angegebenen Namen als großes

Zeichen-Array in den Speicher und legt die Anfangsadresse und Länge

des Arrays auf den Stack.

In obiger Version von count-chars werden die

Start-Adresse und die End-Adresse als Schleifenparameter verwendet,

und i liefert in jeder Iteration die Adresse eines Bytes.

Man kann aber auch einfach von 0 bis zur Länge des Arrays hochzählen,

und die Adressberechnung erst unmittelbar vor dem c@

machen:

: count-chars { addr u -- }

u 0 ?do

addr i + c@ count-char

loop ;

Wir können jetzt auch das Problem der Ausgabe der Ziffern einer Zahl in der richtigen Reihenfolge lösen:

20 constant d-len

here d-len allot constant d

: digits ( n -- )

d d-len + 1-

begin { n d1 }

n while

n 10 mod '0 + d1 c!

n 10 / d1 1 -

repeat

d1 d d-len + d1 - type ;

type ( addr u -- ) gibt einen String

aus. '0 produziert den ASCII-Code von 0.

Die Ziffern 0..9 folgen im ASCII-Code unmittelbar aufeinander, sodass

man für einen Zahlenwert <10 einfach den ASCII-Code von 0

dazuzählen kann und den ASCII-Code der entsprechenden Ziffer erhält.

Das kann man sich auch in Forth veranschaulichen:

: print-ascii ( u l -- )

?do

i emit

loop ;

'9 1 + '0 print-ascii

Bei digits wird das Array vom Ende her gefüllt, damit die

Zeichen danach in der richtigen Reihenfole für type im

Speicher stehen.

Allgemein werden Dateien verwendet, um Daten über eine Sitzung hinweg zu speichern, und um Daten von einem Programm zum anderen zu übertragen; für Datentausch sind Dateien nicht die einzige Möglichkeit, aber eine sehr gebräuchliche.

Eine Text-Datei enthält nur die einzelnen Zeichen und einige ASCII-Kontrollzeichen wie CR (ASCII 13), LF (10), oder beides für das Zeilenende und TAB (9) für die Einrückung. Text-Dateien können mit vielen Werkzeugen relativ einfach verarbeitet werden, und sind deshalb die gebräuchliche Form, Quellcode abzuspeichern, quer über alle Programmiersprachen.

Text-Dateien werden mit einem Text-Editor geschrieben und bearbeitet. Die meisten Programmierer finden irgendwann einmal ihren Lieblings-Editor, und bleiben dem dann dauerhaft treu.

Ein Unterschied zu einem Textverarbeitungsprogramm ist, dass man

bei der Textverarbeitung das Aussehen des Textes (z.B. Schrift-Art,

Schriftgröße, Dicke, Schrägstellung) bestimmen kann; das muss

mitabgespeichert werden, und daher sind die Dateien, die ein Dokument

einer Textverarbeitung speichern, im Normalfall keine Text-Dateien im

oben genannten Sinn; sie sind normalerweise auch spezifisch für das

Textverarbeitungsprogramm und können nur von wenigen anderen

Programmen bearbeitet werden, wenn überhaupt. Man kann sich den

Unterschied auch leicht anschauen, wenn man einen kurzen Text mit

einem Text-Editor schreibt und mit einer Textverarbeitung, und sich

dann die Dateigrößen anschaut, und z.B. mit einem Dump-Programm wie

z.B. hd den Inhalt der Dateien.

Viele Editoren bieten spezielle Unterstützung für die Programmierung, zum Beispiel Einfärben gewisser Elemente (syntax colouring) oder Unterstützung bei der Einrückung. Manche Editoren erlauben den Aufruf des Compilers oder Programmiersystems, oder anderer Werkzeuge, z.B. Debugger. Das führt dann zu Integrierten Entwicklungsumgebungen (integrated developmentenvironments, IDEs) wie z.B. Eclipse.

Wenn Sie mit einem Editor eine Datei datei.fs erstellt

haben, können Sie sie mit

gforth datei.fsausführen. Wenn Sie dabei gleich einen Aufruf machen wollen, den Sie nicht in die Datei hineinschreiben wollen, können Sie den Aufruf auch auf die Kommandozeile schreiben:

gforth char-hist.fs -e 's" slides.tex" slurp-file char-hist bye'Hier sorgt das abschliessende

bye dafür, dass Gforth am

Ende verlassen wird, Gforth wird also in diesem Beispiel als

Script-Sprache eingesetzt.

Zunächst ist zu bemerken, dass das Histogramm-Programm nicht als eine große Definition geschrieben wurde, sondern im mehreren kleineren. Diese kann man dann einzeln testen, und so schon den Fehler eingrenzen, und eventuell doch durch Inspektion finden.

Wenn das mit der Inspektion des Quellcodes nicht wirkt, ist es oft erhellend, zu sehen, was zur Laufzeit passiert. Viele Entwicklungsumgebungen bieten dazu die Möglichkeit, das Programm schrittweise durchzugehen (single-step debugging), und bei jedem Schritt die Daten zu inspizieren.

Auch Gforth bietet diese Möglichkeit, dazu muss man es allerdings

mit gforth-itc starten, statt mit gforth.

Um ein Wort im Single-Step-Modus auszuführen, rufen Sie es

mit dbg wort auf. Z.B.:

s" I will never do anything bad ever again" dbg char-histDabei gibt es in jedem Schritt eine Zeile wie

7FFFF6A4F998 60FFD0 >l -> [ 1 ] 6640464oder

7FFFF6A4F9E0 60FB30 cells -> [ 2 ] 140737331393488 00760Zunächst gibt der Debugger zum

-> aus, dann wartet er

auf eine Eingabe des Benutzers, dann führt er den Schritt aus, und

zeigt das Ergebnis des Schritts auf dem Stack an (die Tiefe des

Stacks, und die Werte auf dem Stack als Zahlen in der aktuellen

Basis).

An der dritten Stelle steht das Wort, das in diesem Schritt ausgeführt

wurde, z.B. cells oder >l.

Wobei >l nicht im Quelcode vorkommt, sondern aus der

Definition der Locals stammt; an der ersten Stelle ist die Adresse des

Codes, der in diesem Schritt ausgeführt wurde, und an zweiter Stelle

der Inhalt der Zelle an dieser Stelle, beides als Hex-Zahl. Das Wort

an dritter Stelle ist eine Interpretation dieser Daten als

Forth-Quellcode, was allerdings z.B. bei Locals nicht so recht gelingt.

Ähnliche Einschränkungen gibt es auch in anderen Umgebungen. Z.B. zeigt gdb bei optimierten C-Programmen zwar Quellcode an, der wird aber dann nicht in der erwarteten Reihenfolge durchschritten, und die Werte von Variablen stimmen dabei oft nicht mit dem überein, was man sich von einer schrittweisen Ausführung des Originalcodes erwarten würde, da die Optimierung z.B. die Reihenfolge von Operationen geändert hat.

Als Befehle ist für uns besonders die Enter-Taste interessant. Sie

führt das Wort komplett aus. Weiters ist auch noch die

Taste n interessant: wenn man sie bei einer Definition

anwendet, führt der Debugger die Definition schrittweise aus. (Wenn

man n bei einem nicht in Forth definierten Wort verwendet,

z.B. >l, zeigt der Debugger den Maschinencode für das

Wort an, oder versucht es zumindest.

Leider ist auf manchen Systemen das installierte Gforth nicht mit dem installierten gdb (der zum Disassemblieren des Maschinencodes verwendet wird) kompatibel, sodass das System dann hängt und nur durch Abschiessen das gdb-Prozesses (z.B. unter Linux mit "killall gdb") zum Weiterarbeiten bewegt werden kann. Sie können die Ausgabe des Disassemblers aber mit

' dump is discode ' 2drop is discodeaber auf einen Speicherdump reduzieren oder ganz weglassen.

Das schrittweise Ausführen eines Programmes kann zwar hilfreich sein, um zu verstehen, wie Programme ausgeführt werden, ist bei tausenden, Millionen, Milliarden oder Billionen Schritten, die Programme typischerweise ausführen, als Debuggingtechnik nicht sehr effektiv; insbesondere wenn man sich bei jedem Schritt noch überlegen muss, ob das Ergebnis jetzt stimmt oder nicht.

Debugger bieten daher Möglichkeiten an, Schritte zu überspringen, auch der Gforth-Single-Step-Debugger.

Nach meiner Erfahrung ist aber auch das nicht besonders effektiv, weil man zu leicht in Versuchung gerät, einfach weiter im Einzelschrittmodus weiterzumachen, statt sich sinnvolle Abkürzungen zu überlegen. Das ist umso verführerischer, weil man traditionellerweise nicht mehr so einfach zurückgehen kann, wenn man einmal zuviel abgekürzt hat.

Dann wäre es schön, das Programm bis zur Fehlermeldung auszführen, und sich dann anzuschauen, welche Werte im Speicher oder am Stack falsch sind, und dann per Rückwärts-Watchpoints die Plätze im Programm zu finden zu finden, wo diese falschen Werte herkommen; wenn die aus anderen, schon falschen Werten berechnet wurden, wiederholt man das ganze für die anderen Wert, ansonsten hat man die Fehlerquelle gefunden (wenn es sich, wie meistens, um einen einfachen Fehler handelt).

Leider ist Rückwärts-Debugging in der Form noch nicht in Gforth implementiert.

Diese Prüfung kann über automatisch überprüfbare Zusicherungen (Assertions) erfolgen. Wenn wir zum Beispiel überprüfen wollen, dass wir bei den Zugriffen auf hist nicht ausserhalb des reservierten Speicherbereichs zugreifen, können wir das wie folgt machen:

: check-in-hist { addr -- addr }

assert( addr hist hist hu hl - cells + within )

addr ;

Dabei muss der Code zwischen assert( und )

eine Zelle auf den Stack legen, die "falsch" (also 0) sein soll, wenn

die Zusicherung nicht erfüllt ist. within ( x1 x2 x3 -- f

) überprüft x2≤x1<x3.

Und dieses Wort check-in-hist können wir dann vor

dem inc in count-char und vor

dem @ in show-hist einfügen.

Assertions fügt man meist schon beim Codieren ein, nicht erst beim Debuggen. Und zwar fügt man sie ein, wenn man so eine automatische Prüfung hinschreiben kann, und wenn man der Quelle der Daten nicht besonders traut, zum Beispiel weil sie aus kniffligem Code kommen, bei dem die Fehlerhäufigkeit meist hoch ist, oder weil das Programmstück von irgendwoher aufgerufen werden kann. Besonders gerne verwendet man daher Assertions, um die Vorbedingungen eines Wortes zu prüfen, soweit möglich.

Neben diesen automatisch prüfbaren Zusicherungen gibt es auch noch Zusicherungen zu Dokumentationszwecken, die als Kommentare hingeschrieben werden. Zum Beispiel sind die Schleifeninvarianten bei unseren fac-Beispielen solche Zusicherungen: Das Überprüfen dieser Invarianten benötigt ein funktionierendes Fac-Wort, sodass es normalerweise unpraktikabel ist, das automatisch zu überprüfen.

Die Vorbedingung der Fac-Wörter könnte man dagegen mit automatisch geprüften assertions prüfen.

Wenn man einmal genug Vertrauen in die Korrektheit des Programmes hat, kann man das Überprüfen der Assertions auch abdrehen, wenn diese Überprüfung zuviel Zeit kostet. In Gforth geht das mit

0 assert-level !vor dem Code, in dem man die Assertions abdrehen will, und

1 assert-level !danach.

show-hist einfügt):

hist.fs:6: failed assertion :1: assertion failed s" bla " >>>char-hist<<< Backtrace: $7FFC4734C988 throw $7FFC47373CC8 c(abort") $7FFC4739F738 (end-assert) $7FFC4739F978 check-in-hist $5F $7F $7FFC4739FAD0 show-histHier sieht man, dass es auf der Kommandozeilenebene ein Fehler in

char-hist passiert ist (das ja direkt von der

Kommandozeile aufgerufen wurde), dieses rief

dann show-hist auf, und das

dann check-in-hist (dazwischen werden noch zwei Zahlen

angezeigt, die vom ?do

stammen. Check-in-hist ruft (end-assert)

auf (Laufzeit-Code, der von assert(...) erzeugt wurde),

und das wiederum c(abort")

und throw.

printf()

heisst.

Diese Debuggingmethode hat einige Vorteile:

." und .s. Aber es gibt in Gforth

noch das Wort ~~ (``Tracer'') für diesen Zweck. Es zeigt

an, wo es im Code steht, und was auf dem Stack ist. Wenn wir

z.B. unser fac-Beispiel damit verzieren

: fac { n -- n! }

n

n 1 ?do ~~ ( n1 )

i ~~ *

loop ;

5 fac .

erhalten wir folgende Ausgabe:

fac.fs:3:<1> 5 fac.fs:4:<2> 5 1 fac.fs:3:<1> 5 fac.fs:4:<2> 5 2 fac.fs:3:<1> 10 fac.fs:4:<2> 10 3 fac.fs:3:<1> 30 fac.fs:4:<2> 30 4 120Hier wird die Position des ausgebenden Tracers immer über den Dateinamen und die Zeile angezeigt (sodass wir verschiedene Tracer unterscheiden können; besonders hilfreich im Zusammenspiel mit Editoren wie Emacs), und den Stack-Inhalt.

Solche Ausgabebefehle platziert man oft unmittelbar hinter einem Kontrollfluss-Wort, um dem Kontrollfluss folgen zu können, oder dort, wo interessante Daten berechnet wurden (und im Falle von Forth besonders gerne dort, wo sie auf dem Stack sind).

Ein häufiges Problem dabei ist, dass man den Fehler falsch behebt, dass die Änderung zwar für eine richtige Behandlung des bisher fehlgeschlagenen Testfall sorgen, aber das Programm dafür in anderen Fällen jetzt ein falsches Ergebnis liefert. Daher sollte man für ein Programm eine Menge von Tests haben (eine Testsuite), die man nach jeder Änderung erneut testet. Solche Tests nennt man Regressionstests, da sie Testen, was in dem Programm schon funktioniert hat; wenn sie nicht mehr funktionieren, ist das ein Rückschritt, also eine Regression. Mit einer guten Testsuite kann man dadurch so einen Fehler finden.

Weiters fügt man einen Testfall oder mehrere zu den Regressionstests dazu, die den Fehler aufdecken würden. Es passiert nämlich doch recht oft, dass ein Fehler zurückkommt, und dann würde man ihn durch diese Testfälle sofort bemerken.

Schon einmal gemachte Fehler sind deswegen häufiger als irgendwelche anderen Fehler, weil viele Fehler nicht zufällig passieren, sondern weil der Teil des Programms, in dem sie vorkommen, besonders schwierig ist, und die für dieses Problem naheliegende (Schein-)Lösung falsch ist.

Zum Beispiel kann es passieren, dass man die Fehlerbehebung trotz der Regressionstests einen Fehler hinterlassen hat, der aber erst nach längerer Zeit auffällt. Und wenn man diesen Fehler dann beheben will, kann es vorkommen, dass man die ursprungliche fehlerhafte Lösung wieder einbaut (weil sich der ursprüngliche Programmierer nicht mehr an den Fehler in dieser Lösung erinnert, oder ein anderer Programmiere diesen Fehler bearbeitet). Dann dienen die Regressionstests als institutionelles Gedächtnis.

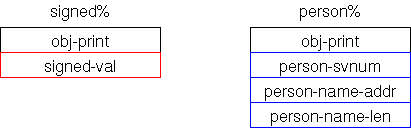

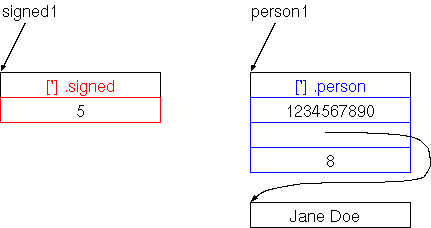

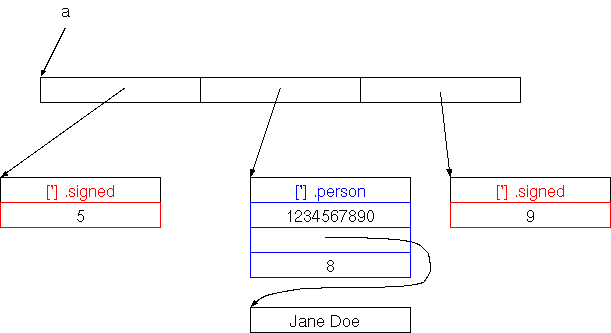

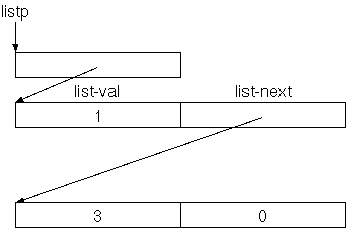

So ein Verbund von Daten wird (nach den Namen in verschiedenen Programmiersprachen) Record oder Struktur genannt, eine Verallgemeinerung davon (auf die wir später eingehen werden) sind Objekte bzw. Klassen. Die Einzelteile eines Records heißen Felder (bzw. bei Objekten Instanzvariablen oder Objektvariablen).

Im Bild oben ist der Record im Speicher in rot dargestellt, in blau die enthaltenen Daten (die Adresse und die Länge eines Strings), und der String (Byte-Array) selbst.

Wie im Bild zu sehen, implementieren wir Records, indem wir die einzelnen Felder hintereinander im Speicher anordnen. Der Unterschied zum Array liegt in der Verwendung, nicht in der Implementierung. Wir könnten jetzt z.B. wir folgt auf die Struktur zugreifen:

: array@ { addr1 -- addr2 u }

addr1 @

addr1 1 cells + @ ;

: array! { addr2 u addr1 -- }

addr2 addr1 !

u addr1 1 cells + ! ;

Bei größeren Programmen, in denen verschiedene Records im Spiel sind,

wird es allerdings bald schwer durchschaubar, ob 1 cells

+ der Zugriff auf das Längenfeld des Array-Deskriptors ist,

oder etwas anderes. Daher ist es sinnvoll, Worte für diese Felder

einzuführen:

: array-addr ( addr1 -- addr2 )

;

: array-len ( addr1 -- addr2 )

1 cells + ;

: array@ { addr1 -- addr2 u }

addr1 array-addr @

addr1 array-len @ ;

: array! { addr2 u addr1 -- }

addr2 addr1 array-addr !

u addr1 array-len ! ;

Neben der Dokumentationswirkung hat die Verwendung

von array-addr und array-len noch weitere

Vorteile: Da die konkrete Anordnung der Felder jetzt nur mehr in

diesen Wörtern präsent ist statt im ganzen Programm, könnte man die

Anordnung der Felder bei Bedarf mit wenig Aufwand ändern.

[Das ist nur ein Beispiel für ein allgemeines Prinzip: Da immer wieder alle möglichen Änderungen in Programmen vorkommen, ist es hilfreich, Implementierungsentscheidungen an einer Stelle zu konzentrieren, damit man bei Bedarf nur diese Stelle ändern muss statt das ganze Programm.]

Da man öfters solche Wörter für Feldzugriffe braucht, gibt es schon eigene Definitionswörter dafür in Gforth. Z.B. können wir unseren Array-Deskriptor wie folgt definieren:

struct cell% field array-addr cell% field array-len end-struct array-desc%Zusätzlich definiert dieser Code das Wort

array-desc%,

das wir zum Beispiel verwenden können, um einen Array-Deskriptor als

Feld in einem anderen Record zu definieren, oder (wie wir später sehen

werden), um Speicher für den Record zu reservieren.

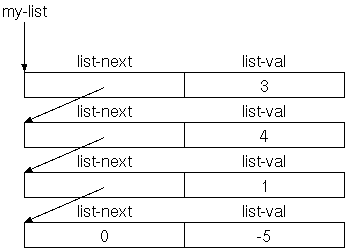

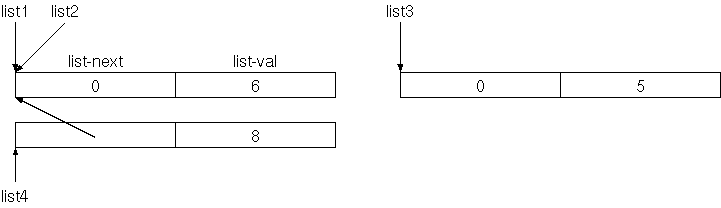

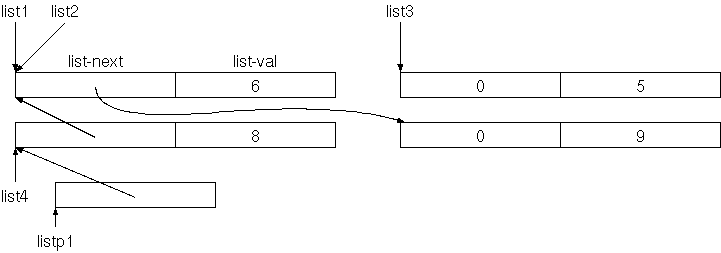

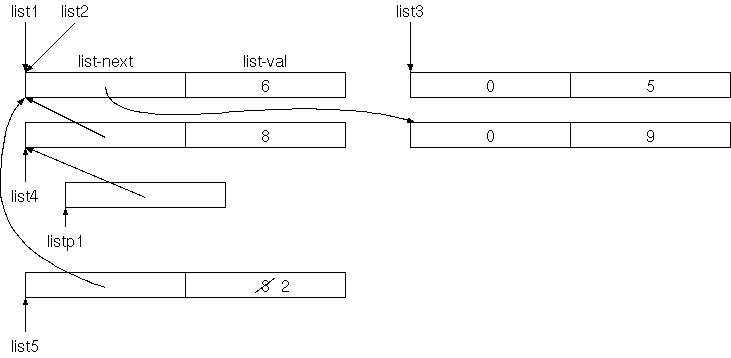

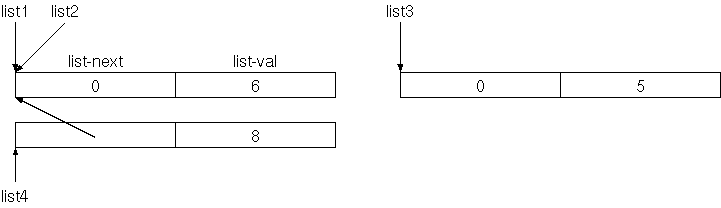

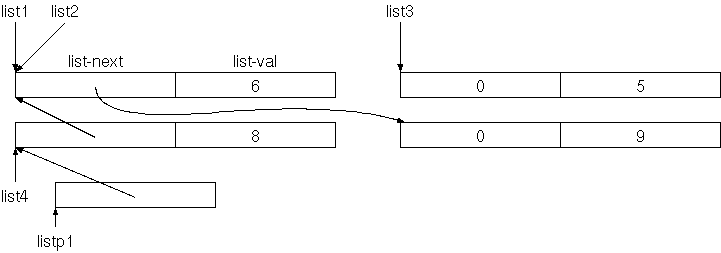

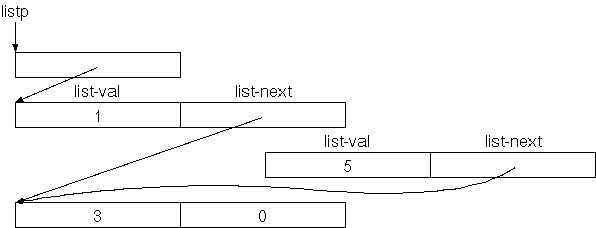

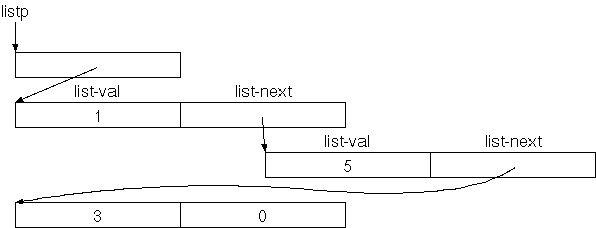

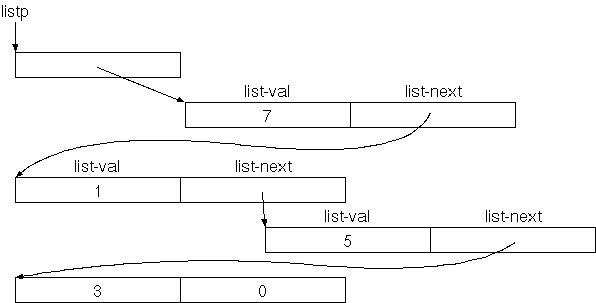

Die oben gezeigte verkettete Liste besteht aus vier gleichen

Records mit je zwei Feldern: Das erste Feld ist die Adresse des

nächsten Records in der Liste (das nächste Listenelement), das zweite

Feld enthält die Nutzdaten, in unserem Fall (der Einfachkeit halber)

eine ganze Zahl. Wenn es kein nächstes Listenelement gibt), speichern

wir 0 in das Feld list-next.

Bei solchen Datenstrukturen, bei denen Records die Adressen anderer Records enthalten, die Records also aufeinander zeigen, nennt man die Records auch Knoten (node) und die Adressen/Zeiger auch (gerichtete) Kanten (edge), abgeleitet von der Graphentheorie in der Mathematik; diese Datenstrukturen kann man nämlich auch als gerichtete Graphen sehen.

Hier die Definition der Listenrecords:

struct cell% field list-next cell% field list-val end-struct list%Wir können ein Listen-Element wie folgt erzeugen:

: new-list { list1 val -- list2 }

list% %allot { list2 }

list1 list2 list-next !

val list2 list-val !

list2 ;

Wobei %allot ( record-desc -- addr ) Platz für den Record

im Dictionary reserviert und die Anfangsadresse des reservierten

Platzes auf den Stack legt.

Mit new-list können wir die oben gezeigte Liste wie

folgt aufbauen:

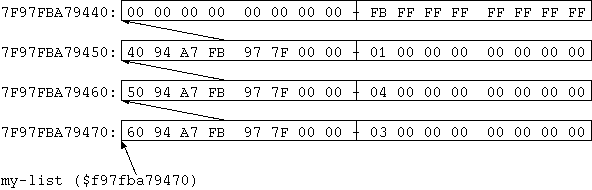

0 -5 new-list 1 new-list 4 new-list 3 new-list constant my-listMan kann sich die Liste jetzt im Speicher anschauen:

my-list hex. $7F97FBA79470 ok my-list 6 cells - 8 cells dump 7F97FBA79440: 00 00 00 00 00 00 00 00 - FB FF FF FF FF FF FF FF ................ 7F97FBA79450: 40 94 A7 FB 97 7F 00 00 - 01 00 00 00 00 00 00 00 @............... 7F97FBA79460: 50 94 A7 FB 97 7F 00 00 - 04 00 00 00 00 00 00 00 P............... 7F97FBA79470: 60 94 A7 FB 97 7F 00 00 - 03 00 00 00 00 00 00 00 `...............[

my-list zeigt auf den Anfang des letzten Records, davor sind drei

andere mit jeweils zwei Zellen, insgesamt sind 4 Records à 2 Zellen

vorhanden.]

Mit folgendem Wort können wir die Elemente der Liste ausgeben:

: .list ( list -- )

begin { l }

l while

l list-val @ .

l list-next @

repeat ;

my-list .list

Im obigen Beispiel wurde eine Liste direkt gebaut, mit dem letzten

Element beginnend, und das Ergebnis haben wir uns dann in einer

Konstante gemerkt. Wenn wir in eine Liste nachträglich ein Element

einfügen wollen, ist die Konstante zum merken nicht sehr praktisch.

Stattdessen können wir uns eine Zelle im Speicher reservieren und die

Liste dort abspeichern:

here 1 cells allot constant lp my-list lp !Jetzt zeigt

lp auf die Zelle, in der die Adresse des

ersten Records der Liste steht. Wir können jetzt ein weiteres Element

vorne in diese Liste einfügen:

lp @ 7 new-list lp ! lp @ .listDa wir das vielleicht oefters machen möchten, machen wir eine Definition dafür:

: insert { val listp -- }

listp @ val new-list listp ! ;

9 lp insert

lp @ .list

Einfügen am Ende ist etwas komplizierter, weil wir zuerst das Ende

suchen müssen:

: insert-end { val listp -- }

listp begin { lp1 }

lp1 @ while

lp1 @ list-next

repeat

0 val new-list lp1 ! ;

11 lp insert-end

lp @ .list

Bemerkenswert ist hier: Wir brauchen die Adresse (nicht den Inhalt)

der Zelle, in der die abschließende 0 gespeichert ist, damit wir dort

das Element anhängen können. Diese Möglichkeit, mit Referenzen auf

Speicherstellen umzugehen, gibt es in einer Reihe von

Programmiersprachen, aber nicht in Java. Wir werden später sehen, wie

wir dieses Problem in Java umschiffen.

Bemerkung: Wenn man öfters am Ende einfügen will, kann man sich auch die Adresse der Zelle mit der abschließenden 0 merken, zusätzlich zu der Adresse der Zelle, in der das erste Element steht.

Wie können wir alle Werte einer Liste aufaddieren?

: sum-list { list -- n }

0 list begin { l } ( n1 )

l while

l list-val @ +

l list-next @

repeat ;

lp @ sum-list .

Wenn wir uns sum-list anschauen, sehen wir große

Ähnlichkeiten zu .list; im Schleifenkörper ist

jetzt + statt ., aber sonst ist alles gleich

(abgesehen vom Stack-Bild-Kommentar). Tatsächlich werden alle Wörter,

die die Liste von vorne nach hinten durchgehen und mit jedem Element

etwas, machen, so ausschauen. Wir können diese Gemeinsamkeit auch in

ein eigenes Wort faktorisieren:

: do-list ( x1 list xt -- x2 ) { xt }

begin { l } ( x )

l while

l list-val @ xt execute

l list-next @

repeat ;

: .list ( list -- )

['] . do-list ;

: sum-list { list -- n }

0 list ['] + do-list ;

lp @ .list

lp @ sum-list .

Wir übergeben an do-list nicht nur die Liste, sondern

auch ein Wort, repräsentiert durch die Anfangsadresse dieses Wortes;

diese Adresse heißt in Forth Execution token oder kurz xt. Dieses xt

wird dann in der Schleife mit execute ( ... xt -- ... )

ausgeführt. Das Execution Token eines Wortes erhält man innerhalb

einer Definition mit ['] wort und ausserhalb

mit ' wort. D.h, ausserhalb einer Definition

ist 3 ' . execute das gleiche wie 3 ..

Wir können mit do-list auch noch weitere Dinge tun, z.B. das

Maximum der Listen-Elemente berechnen:

-$80000000 lp @ ' max do-list .

Damit die Stack-Tiefe im Schleifenrumpf gleich bleibt, muss das von

xt repräsentierte Wort eine Zelle mehr vom Stack nehmen als es auf den

Stack legt. Der bei do-list angegebene Stack-Effekt und

die Stack-Bilder ist für den Fall geschrieben, dass man das xt eines

Wortes mit dem Stack-Effekt ( x1 x2 -- x3 ) übergibt

(z.B. + oder max), aber man sieht

am .list-Beispiel, dass auch der Stack-Effekt ( x2 -- )

möglich ist; der Stack-Effekt von do-list ist dann ( list

xt -- ).

exitwhile zu berücksichtigen. Eine andere Möglichkeit

ist es, die ganze Definition bei Erreichen einer der

Abbruchbedingungen zu verlassen (die andere Abbruchbedingung wird

weiterhin mit while abgefangen). Zum Verlassen der

Definition gibt es das Wort exit.

Als Beispiel suchen wir in unserer Liste von Zahlen nach einer konkreten Zahl:

: member? { key liste -- flag }

liste begin { l }

l while

l list-val @ key = if

true exit endif

l list-next @

repeat

false ;

Hier verwenden wir dieselbe Struktur wie bei den bisherigen Schleifen

über Listen, das while bricht also ab, wenn das Ende der

Liste erreicht ist. Für den Abbruch beim Finden des gesuchten Wertes

verwenden wir ein exit in

einem if...endif. Dabei muss man beachten,

dass die Stack-Effekte bei beiden Möglichkeiten, die Definition zu

verlassen, zusammenpassen müssen.

Auch wenn die Struktur dieses Wortes durchaus in

das do-list-Schema zu passen scheint, kann man hier

do-list nicht verwenden: Man müsste key = if true

exit endif in eine eigene Definition auslagern, aber da würde

das exit nur diese Definition verlassen, nicht

aber do-list.

Wenn man exit in ?do...loop

einsetzt, muss man vor dem exit noch unloop

schreiben.

Übung: Schreiben Sie ein Wort, das in einem Array nach einem bestimmten Element sucht.

+ - * / < .

+ - * u< u.

+ - @ ! (zweiter Parameter)

! (erster Parameter)

+ - c@ c! (zweiter Parameter)

emit c! (erster Parameter)

execute

Diese Sicht, Datentypen über die Wörter bzw. Operationen zu definieren, die auf ihnen arbeiten, nennt man strukturelle Typisierung oder auch duck typing (abgeleitet von dem Satz: "When I see a bird that walks like a duck and swims like a duck and quacks like a duck, I call that bird a duck").

Wobei Zahlen, Adressen, Flags, und Execution Tokens auch Zellen sind

und damit ebenfalls als erster Parameter in ! vorkommen

dürfen. Man spricht davon, dass Zahlen, Adressen, Flags und Execution

Tokens Untertypen des Typs Zelle sind. Wenn man ein Wort

geschrieben hat, das für Zellen im Allgemeinen arbeitet, funktioniert

es für alle Arten von Zellen, ob es jetzt eine Zahl ist oder eine

Adresse (Ersetzbarkeitsprinzip). Wir werden Untertypen und

Ersetzbarkeit später genauer betrachten.

Bei den Adressen von Zellen ist es oft sinnvoll, noch weiter zu

unterscheiden (also Untertypen des Typs "Adresse von Zelle" zu

verwenden). Zum Beispiel übergibt man list-next die

Adresse eines Listenknoten und erhält die Adresse einer Zelle, in der

0 oder die Adresse eines Listenknoten steht; und während

man .list die Adresse eines Listenknoten (oder 0)

übergibt, ist das zweite Argument bei insert

und insert-end die Adresse einer Zelle, in der 0 oder die

Adresse eines Listenknoten steht.

Wenn man ein Wort auf ein Datum vom falschen Typ anwendet, wird das Programm nicht das gewünschte Ergebnis liefern; so etwas ist ein Typfehler. In vielen Programmiersprachen werden Typfehler vom Compiler (statische Typüberprüfung) oder zur Laufzeit (dynamische Typüberprüfung) erkannt und gemeldet, in Forth nicht.

In Forth liegt es am Programmierer, Typfehler zu vermeiden. Dazu werden in den Stack-Bildern und Stack-Effekt-Kommentaren die Stack-Elemente auch entsprechend den Typen benannt. Für einfache Typen wie vorzeichenbehaftete bzw. vorzeichenlose ganze Zahlen gibt es da Konventionen ("n" bzw. "u"), bei komplizierteren Typen muss man sich selbst welche setzten; z.B. steht bei den Listenwörtern oben "list" für die Adresse eines Listenknotens (oder 0) und "listp" (für list pointer) für die Adresse einer Zelle, in der 0 oder die Adresse eines Listenknoten steht.

Die Typen der Zellen auf dem Stack sind also eine statische Eigenschaft, genau wie die Stacktiefe. Allerdings hat man es nicht nur im Stack mit Typen zu tun, sondern auch im Speicher.

Einige Wörter funktionieren auf mehreren Typen,

z.B. funktioniert + für vorzeichenlose und

vorzeichenbehaftete Zahlen, und um Adressen und Zahlen zu addieren.

Das liegt aber nur daran, dass Adressen auch Zahlen sind, und dass die

Repräsentation der vorzeichenbehafteten Zahlen genau so gewählt wurde,

dass die vorzeichenlose Addition auch für vorzeichenbehaftete Zahlen

funktioniert.

Im allgemeinen funktioniert ein Wort aber nur für einen Typ. Z.B. haben wir verschiedene Wörter für die Ausgabe:

.list ein Wort, das spezifisch für

vorzeichenbehaftete ganze Zahlen ist, nämlich . (weiters

verwendet sum-list das Wort +, das z.B. nicht

sinnvoll auf execution tokens angewendet werden kann).

Für die meisten Wörter (list-next list-val new-list insert

insert-end do-list) spielt es aber keine Rolle, welcher

Untertyp von Zellen als Nutzlast gespeichert ist (eine Zelle muss es

aber sein). Man kann diese Wörter daher allgemeiner benutzen als

ursprünglich vorgesehen, nämlich für alle Listen mit Zellen als

Nutzlast. Diese Listen sind funktionieren also generisch für Zellen

und alle Untertypen von Zelle. Diese Eigenschaft nennt man daher

Generizität.

Wenn man allerdings z.B. .list auf einer Liste, die